Forscher zeigen: So einfach lassen sich LLMs in Robotern mit einem Jailbreak missbrauchen

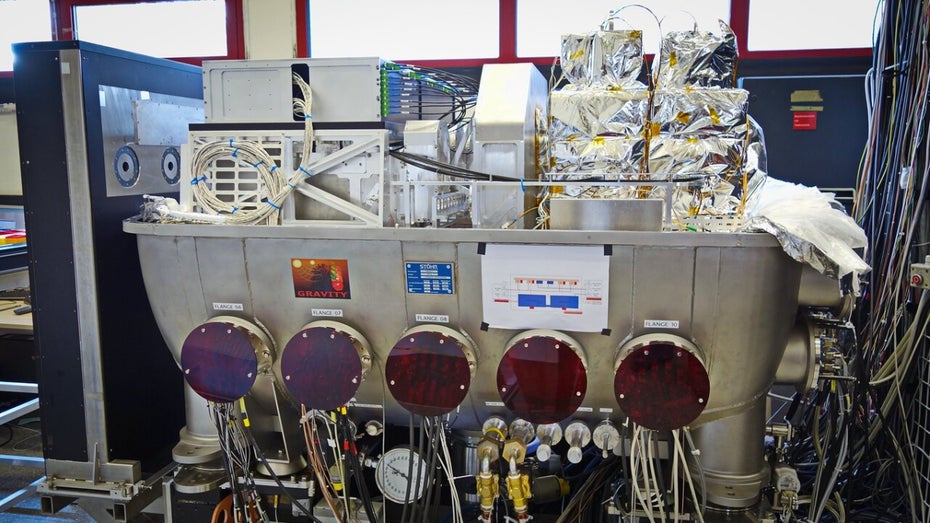

Damit Roboter in dieser Welt navigieren, Gefahren einschätzen und Regeln einhalten können, braucht es große Sprachmodelle. Allerdings lassen sich die LLMs laut einigen Forscher:innen leicht aushebeln. Und diese Jailbreaks hätten gravierende Konsequenzen. weiterlesen auf t3n.de

Wie ist Ihre Reaktion?

/origin-imgresizer.eurosport.com/2024/11/25/4065752-82452704-310-310.jpg)

/origin-imgresizer.eurosport.com/2024/11/25/4065563-82448924-310-310.jpg)

/origin-imgresizer.eurosport.com/2024/11/25/4065548-82448624-310-310.jpg)

/origin-imgresizer.eurosport.com/2024/11/24/4065173-82441124-310-310.png)

/origin-imgresizer.eurosport.com/2024/11/24/4065190-82441464-310-310.png)